Sora 2: O deepfake εφιάλτης του Σαμ Άλτμαν έφερε το τέλος κάθε αλήθειας – «Βγείτε από τα social media»

Η κυκλοφορία της τελευταίας έκδοσης του Sora 2 από την OpenAI, στις 30 Σεπτεμβρίου 2025, δεν είναι απλά μια νέα εποχή, είναι η καταστροφή της αλήθειας online

«Σήμερα είναι η τελευταία μέρα που πιστεύω οτιδήποτε βλέπω στο διαδίκτυο» γράφουν οι χρήστες στα μέσα κοινωνικής δικτύωσης μετά την επική κυκλοφορία σε όρους δημοφιλιάς του Sora 2, της εφαρμογής που δημιουργεί εξελιγμένα, υψηλής ποιότητας βίντεο με Τεχνητή Νοημοσύνη από την OpenAI του Σαμ Άλτμαν.

Η πρεμιέρα της εφαρμογής καθιστά σχεδόν αδύνατη τη διάκριση από τα πραγματικά βίντεο σημειώνει το Axios ενώ ο αγώνας δρόμου για την αναγνώριση ψεύτικου περιεχομένου έχει πλέον ξεκινήσει, με τους ειδικούς να τονίζουν πως η ικανότητα να αναγνωρίζουμε τα σημάδια είναι μια «νέα δεξιότητα ψηφιακού γραμματισμού».

Η νέα εφαρμογή τεχνητής νοημοσύνης Sora της OpenAI ξεπέρασε το ένα εκατομμύριο λήψεις μέσα σε λιγότερο από πέντε ημέρες, φτάνοντας το ορόσημο πιο γρήγορα απ’ ό,τι το ChatGPT όταν κυκλοφόρησε σημειώνει το BBC για την εφαρμογή που έχει καρφωθεί στην κορυφή του Apple App Store στις Ηνωμένες Πολιτείες και έχει τη δυνατότητα να δημιουργήσει ρεαλιστικά βίντεο δέκα δευτερολέπτων μετά από γραπτές εντολές/περιγραφές (prompts).

Ο επικεφαλής της ομάδας ανάπτυξης, Bill Peebles, ανακοίνωσε τα στοιχεία σε ανάρτησή του στην πλατφόρμα Χ, σημειώνοντας πως η «εκρηκτική ανάπτυξη» της Sora ήρθε παρότι η εφαρμογή είναι διαθέσιμη μόνο στη Βόρεια Αμερική και κατόπιν πρόσκλησης αλλά η άφιξη δεν είναι χωρίς αντιδράσεις.

Διάσημοι, influencer, κληρονόμοι πεθαμένων star, πρακτορεία και στούντιο απειλούν με μηνύσεις απαιτώντας μέτρα που να προστατεύει το υλικό τις απεικονίσεις αποθανόντων δημοσίων προσώπων ενώ η OpenAI προσπαθεί να περιορίσει τη ζημιά υποσχόμενη ότι θα λάβει μέτρα για να την προστασία πνευματικών δικαιωμτάων.

Μόλις πρόσφατα, η Ζέλντα Γουίλιαμς, κόρη του ηθοποιού Ρόμπιν Γουίλιαμς, ζήτησε από τους χρήστες να σταματήσουν να της στέλνουν βίντεο που δείχνουν τον πατέρα της σε σκηνές δημιουργημένες από τεχνητή νοημοσύνη, μια έκκληση που αρκετά αμερικανικά μέσα συνέδεσαν με την αυξανόμενη δημοτικότητα της Sora.

Απαντώντας στις επικρίσεις, εκπρόσωπος της OpenAI δήλωσε στο Axios ότι υπάρχουν «ισχυρά επιχειρήματα υπέρ της ελευθερίας του λόγου» όσον αφορά την απεικόνιση ιστορικών προσώπων ενώ αναφορικά για δημόσια πρόσωπα που έχουν πεθάνει πρόσφατα «οι εξουσιοδοτημένοι εκπρόσωποι μπορούν να ζητήσουν να μην χρησιμοποιείται η εικόνα τους».

Νέα Τάξη Ψεύτικων Πραγμάτων

i have the most liked video on sora 2 right now, i will be enjoying this short moment while it lasts

cctv footage of sam stealing gpus at target for sora inference pic.twitter.com/B86qzUGlMq

— gabriel (@GabrielPeterss4) September 30, 2025

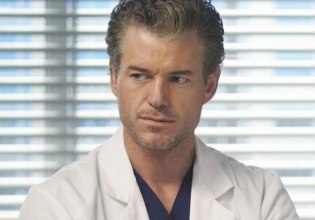

Το Sora 2 είναι όντως μια επανάσταση στα βίντεο AI φέρνοντας την deepfake Νέα Τάξη Πραγμάτων προ των πυλών με πολλά clips να περιλαμβάνουν χαρακτήρες από ταινίες, τηλεοπτικές σειρές ή βιντεοπαιχνίδια αλλά και πρόσπωα από τη δημόσια σφαίρα (πολιτικούς, επιχειρηματίες κα.) σε ευφάνταστες, σουρεαλιστικές αλλά και απίθανα ρεαλιστικές στην απεικόνιση τους σκηνές.

Σε ένα από τα πιο πολυσυζητημένα βίντεο, ο διευθύνων σύμβουλος της OpenAI, Σαμ Άλτμαν, εμφανίζεται (μέσω deepfake) μαζί με χαρακτήρες των Pokémon, λέγοντας χαριτολογώντας: «Ελπίζω η Nintendo να μη μας μηνύσει», σύμφωνα με το CNBC, σε άλλο δημοφιλές φαίνεται να ψήνει και να τρώει τον Pikachu (η Nintendo δεν έχει προχωρήσει σε μηνύσεις) και σε τρίτο κλέβει GPUs για τις ανάγκες της εταιρείεας του.

Σε ανάρτησή του στις 4 Οκτωβρίου, ο Άλτμαν ομολόγησε ότι «η εταιρεία μαθαίνει γρήγορα από τον τρόπο με τον οποίο οι χρήστες αξιοποιούν τη Sora, βρίσκεται σε συνεχή επικοινωνία με δημιουργούς, δικαιούχους και άλλες ενδιαφερόμενες πλευρές» και σκοπεύει να δώσει στους δικαιούχους μεγαλύτερο έλεγχο στη δημιουργία χαρακτήρων ενώ εξετάζεται ακόμη και σύστημα διαμοιρασμού εσόδων για το μέλλον.

Η OpenAI είχε υποσχεθεί δικλείδες ασφαλείας, όπως την προσθήκη ενός ορατού υδατογραφήματος (watermark) με το λογότυπο του Sora σε κάθε βίντεο, καθώς και αόρατων διαπιστευτηρίων περιεχομένου (content credentials).

Ωστόσο, μέσα σε μόλις μία εβδομάδα από την κυκλοφορία της εφαρμογής, τα διαδικτυακά tutorials για την αφαίρεση του υδατογραφήματος κατέκλυσαν το YouTube, το Reddit και το TikTok.

Όπως επισημαίνει ο Τζέρεμι Καράσκο, ιδρυτής της Showtools.ai, «ορισμένα εργαλεία αφαίρεσης είναι σχεδόν τέλεια ή ανεπαίσθητα, ειδικά αν το βίντεο είναι πολύ απλό».

Το πιο ανησυχητικό είναι πως η OpenAI κυκλοφόρησε ήδη το Sora 2 Pro, με βίντεο πολύ υψηλότερης ποιότητας που δεν φέρουν υδατογράφημα. Ο Καράσκο εκτιμά ότι το 90% των ανθρώπων δεν θα είναι σε θέση να ξεχωρίσει με την πρώτη ματιά ένα πολύ καλό ψεύτικο βίντεο.

«Αν σας ξεγελάσει ένα τεχνητό πόσουμ που τρώει καραμέλες, αυτό δεν σημαίνει ότι είστε ανόητοι», λέει ο Καράσκο. «Είναι μια ευκαιρία να μάθετε αν μπορείτε να διακρίνετε την αλήθεια από το ψέμα».

Οδηγός επιβίωσης: Πώς να εντοπίσετε ένα deepfake

@showtoolsai How to spot AI videos – animals on trampolines #bunnies #dog #bear #bunny #ai ♬ original sound – showtools

Οι τεχνολογικοί κολοσσοί (YouTube, TikTok, Meta) απαιτούν από τους δημιουργούς να αποκαλύπτουν το περιεχόμενο που δημιουργείται με Α.Ι. όταν αυτό φαίνεται ρεαλιστικό, αλλά η μάχη ενάντια στην παραπληροφόρηση εξελίσσεται σε ένα διαρκές «whack-a-mole» για τους συντονιστές.

Για να προστατευτείτε, ακολουθήστε τις συμβουλές των ειδικών:

Ελέγξτε την πηγή, εμπιστευτείτε το ένστικτό σας. Όταν όλα μοιάζουν πιστευτά, εμπιστευτείτε το κριτήριο σας, Εάν κάτι φαίνεται έστω και ελαφρώς «περίεργο» (off), το ένστικτό σας θα πρέπει να σας ωθήσει να ψάξετε βαθύτερα.

Δώστε ιδιαίτερη προσοχή σε υλικό «κάμερας». Αν το βίντεο μοιάζει με πλάνα κάμερας ασφαλείας ή κάμερας σώματος (bodycam), μπορεί να είναι deepfake. Οι γεννήτριες Α.Ι. είναι ιδιαίτερα ικανές στη δημιουργία αυτού του τύπου υλικού, καθώς πιθανώς επειδή έχουν εκπαιδευτεί σε μεγάλο όγκο τέτοιων, συχνά κοκκωδών (grainy), βίντεο.

Τέλος, επαληθεύστε την πηγή του δημιουργού. Αν ο δημιουργός ανεβάζει υλικό πριν από το 2024, μπορείτε να υποθέσετε ότι δεν δημιουργήθηκε με Α.Ι. (αν και τα ειδικά εφέ υπήρχαν πάντα).

@showtoolsai Here’s how to see the AI vibe… but then look closer because it’s just a vibe #meetcute #adorable #dating #goals #aivideo This video was inspired by a @Sydney Benjamin ♬ original sound – showtools

Αναζητήστε φυσικές ανακολουθίες (inconsistencies) όπως χείλη που δεν συγχρονίζονται με την ομιλία ή κινούνται αφύσικα.

Ψάξτε για το «σπογγώδες μπλοκ» ή θαμπά σημεία όπου θα έπρεπε να υπήρχε το υδατογράφημα. Παρατηρήστε αν αντικείμενα εξαφανίζονται χωρίς εξήγηση, αν περνούν το ένα μέσα από το άλλο, ή αν παραβιάζονται οι νόμοι της φυσικής και της βαρύτητας.

Δώστε σημασία στη διάρκεια του κλιπ. Οι περισσότερες εκδόσεις μοντέλων Α.Ι. δημιουργούν βίντεο που δεν ξεπερνούν τα 10 δευτερόλεπτα (αν και αυτό αλλάζει). Ένα μεγαλύτερο βίντεο είναι πιθανότερο να είναι πραγματικό.

Διπλή παγίδα

Η ραγδαία εξέλιξη της Α.Ι. δημιουργεί μια διπλή παγίδα για τους χρήστες σημειώνουν οι New York Times. Τα ρεαλιστικά βίντεο Α.Ι. οδηγούν τους ανθρώπους να αμφισβητούν αυθεντικό υλικό, υπονομεύοντας το ταλέντο, το χιούμορ και τις φυσικές ικανότητες των πραγματικών δημιουργών.

Eπιπλέον, όσο περισσότερο χρόνο αφιερώνει κάποιος μελετώντας ένα βίντεο για να αναζητήσει τα λάθη που μπορούν να μαρτυρήσουν την προέλευση του (π.χ. έξτρα δάχτυλα ή ασυνέπειες σε φυσικούς νόμους), τόσο περισσότερο «εκπαιδεύει» τον αλγόριθμο να του φέρνει τέτοιου είδους περιεχόμενο στην οθόνη.

Ο Καράσκο προτείνει να μπλοκάρετε τους λογαριασμούς που δημιουργούν περιεχόμενο Α.Ι. για να σηματοδοτήσετε την αντίθεσή σας στην πλατφόρμα.

«Αν θεωρείτε τον εντοπισμό βίντεο Α.Ι. ως μια ακόμη δεξιότητα ψηφιακού γραμματισμού, [η προσπάθεια] λειτουργεί. Αλλά, αν νομίζετε ότι θα μπορείτε πάντα να βρίσκετε τη λύση, αυτό δεν πρόκειται να συμβεί» επιβεβαιώνει καθώς η μόνη αλήθεια είναι ότι η τεχνολογία Α.Ι. θα γίνεται μόνο καλύτερη, μεγαλύτερη σε διάρκεια και δυσκολότερη στον εντοπισμό.

Η OpenAI, η εταιρεία πίσω από το δημοφιλές chatbot ChatGPT, κυκλοφόρησε μια τεχνολογία για την οποία ο κόσμος μάλλον δεν είναι έτοιμος γράφουν οι NYT.

Η δωρεάν εφαρμογή Sora επιτρέπει στους χρήστες να δημιουργούν άμεσα ρεαλιστικότατα βίντεο με Τεχνητή Νοημοσύνη (Α.Ι.), πληκτρολογώντας απλώς μια περιγραφή, όπως «βίντεο από κάμερα αστυνομικού που συλλαμβάνει έναν σκύλο επειδή έκλεψε rib-eye από Costco».

Διασκεδαστικά εφιαλτικό

Το Sora, το οποίο έγινε άμεσα η πιο δημοφιλής δωρεάν εφαρμογή είναι τόσο διασκεδαστικό, όσο και ανησυχητικό. Ενώ πολλοί το χρησιμοποιούν για αστεία βίντεο (όπως ψεύτικα πλάνα με ρακούν σε αεροπλάνο ή γάτες να αιωρούνται), άλλοι το επιστρατεύουν για κακόβουλους σκοπούς, όπως η διάδοση παραπληροφόρησης με ψεύτικα βίντεο ασφαλείας για ανύπαρκτα εγκλήματα.

Η έλευση του Sora, μαζί με παρόμοιες γεννήτριες βίντεο από τη Meta και την Google, σηματοδοτεί ένα κομβικό σημείο, το τέλος της οπτικής αλήθειας.

Η ιδέα ότι το βίντεο μπορεί να λειτουργήσει ως ένα αντικειμενικό ντοκουμέντο της πραγματικότητας, όπως την ξέραμε, έχει πλέον παρέλθει και η κοινωνία καλείται να αντιμετωπίζει τα βίντεο με τον ίδιο σκεπτικισμό που αντιμετωπίζει τα γραπτά κείμενα.

Το τέλος των ντοκουμέντων

«Ο εγκέφαλός μας είναι ισχυρά προγραμματισμένος να πιστεύει ό,τι βλέπουμε, αλλά μπορούμε και πρέπει να μάθουμε να σταματάμε και να σκεφτόμαστε εάν ένα βίντεο, ή οποιοδήποτε μέσο, είναι κάτι που συνέβη στον πραγματικό κόσμο», δήλωσε ο Ρεν Νγκ (Ren Ng), καθηγητής Επιστήμης Υπολογιστών στο Πανεπιστήμιο της Καλιφόρνια στο Μπέρκλεϊ.

Στο παρελθόν, όταν οι φωτογραφίες μπορούν εύκολα να επεξεργαστούν και να πλαστογραφηθούν, το βίντεο – που απαιτούσε εξειδίκευση – έγινε ο «κανόνας» για την απόδειξη της νομιμότητας. Τώρα, κι αυτό έχει πάψει να ισχύει.

Το άμεσο συμπέρασμα είναι ότι κάθε σύντομο βίντεο που βλέπετε σε εφαρμογές όπως το TikTok, τα Reels του Instagram, το YouTube Shorts και το Snapchat έχει πλέον υψηλή πιθανότητα να είναι ψεύτικο.

@guardianaustraliaThis video is real, mostly. Other videos in your feed might not be. OpenAI’s newest video generator, Sora 2 was launched last week. The app allows users to generate short videos based on a text prompt – and people are reporting seeing a lot of content featuring the faces and voices of real people and copyrighted characters. Have any videos fooled you into thinking they are real this week? Rafqa Touma spoke to Guardian Australia technology reporter Josh Taylor to find out more about the release.♬ original sound – Guardian Australia

Το Sora σηματοδοτεί ένα σημείο καμπής στην εποχή της ψηφιακής πλαστογραφίας απαιτώντας από εμάς να αμφισβητούμε ως καταναλωτές και χρήστες να αμφισβητούμε τα πάντα.

«Κανείς πλέον δεν θα δέχεται τα βίντεο ως απόδειξη για οτιδήποτε», σχολίασε ο Λούκας Χάνσεν, ιδρυτής του CivAI, ενός μη κερδοσκοπικού οργανισμού που ενημερώνει για τις δυνατότητες της Α.Ι.

«Βγείτε από τα μέσα κοινωνικής δικτύωσης»

Οι περιορισμοί της OpenAI αποτρέπουν τη δημιουργία βίντεο με σεξουαλικό περιεχόμενο, κακόβουλες ιατρικές συμβουλές ή τρομοκρατική προπαγάνδα. Ωστόσο, δοκιμές έχουν δείξει ότι το Sora μπορεί εύκολα να δημιουργήσει ψεύτικα πλάνα κάμερας αυτοκινήτου για χρήση σε ασφαλιστική απάτη (π.χ. σύγκρουση Toyota Prius με μεγάλο φορτηγό), βίντεο με αμφίβολους ισχυρισμούς για την υγεία (π.χ. μια γυναίκα να αναφέρει ανύπαρκτες μελέτες για τα οφέλη του τηγανητού κοτόπουλου) αλλά και βίντεο δυσφήμισης με πλαστά δελτία ειδήσεων που κάνουν υποτιμητικά σχόλια για άτομα.

Όσο και αν επιμένει η OpenAI ότι η ενσωμάτωση τεχνολογιών ιχνηλάτησης -όπως υδατογραφήματα και ψηφιακές υπογραφές- προστατεύουν τον χρήστη, οι δημιουργοί περιεχομένου ήδη δουλεύουν για να ξεπεράσουν κάθε εμπόδιο «χτίζοντας» μια ζώνη του λυκόφωτος γύρω μας.

Οι ειδικοί επισημαίνουν ότι κάθε συμβουλή για την αναγνώριση ενός βίντεο που δημιουργήθηκε από Α.Ι. είναι βραχύβια, καθώς η τεχνολογία βελτιώνεται ραγδαία.

Ο Χάνι Φαρίντ, καθηγητής Επιστήμης Υπολογιστών στο Μπέρκλεϊ, δήλωσε ότι τα μέσα κοινωνικής δικτύωσης έχουν μετατραπεί σε έναν «πλήρη σκουπιδότοπο». Για τον ίδιο, ο μόνος σίγουρος τρόπος για να μην εκτεθεί κανείς σε deepfake προϊόντα είναι η διακοπή χρήσης εφαρμογών όπως το TikTok και το Instagram.

Η πρόταση του είναι ειλικρινής αλλά και μάλλον ανέφικτη καθώς τα social media είναι το ναρκωτικό του σήμερα. Άλλωστε ποιός ανάμεσα μας μπορεί να αντισταθεί σε όλα τα παρακάτω βίντεο, 100% ψεύτικα, 100% σαν αλήθεια.

- ΗΠΑ: Σταματούν από αύριο την είσπραξη των δασμών που ακύρωσε το Ανώτατο Δικαστήριο

- «Κολυμπώντας στον αέρα»: Πρεμιέρα στο θέατρο 104

- Ισχυρός σεισμός 6,1 Ρίχτερ σημειώθηκε στην Αλάσκα

- «Φωτιά» στην Premier League: Το πρόγραμμα Άρσεναλ και Μάντσεστερ Σίτι μέχρι το φινάλε

- Οι δραστηριότητες που μας βοηθούν να ζήσουμε περισσότερο – Και δεν έχουν σχέση με τη γυμναστική

- Super League: Το πρόγραμμα ΑΕΚ, Ολυμπιακού, ΠΑΟΚ ως το φινάλε της κανονικής διάρκειας

![Άκρως Ζωδιακό: Τα Do’s και Don’ts στα ζώδια σήμερα [Δευτέρα 23.02.2026]](https://www.in.gr/wp-content/uploads/2026/02/franz-nawrath-0vk_5JmDDZw-unsplash-315x220.jpg)

![Άκρως Ζωδιακό: Τα Do’s και τα Don’ts της εβδομάδας [22.02 – 28.02.2026]](https://www.in.gr/wp-content/uploads/2026/02/POSTER-copy-12-315x220.jpg)

![Άκρως Ζωδιακό: Τα Do’s και Don’ts στα ζώδια σήμερα [Κυριακή 22.02.2026]](https://www.in.gr/wp-content/uploads/2026/02/tony-chen-9hX9N-wMyzQ-unsplash-1-315x220.jpg)